原文:Testing in the Age of AI: Navigating the New Software Quality Frontier

作者:Vaibhav Kulshrestha

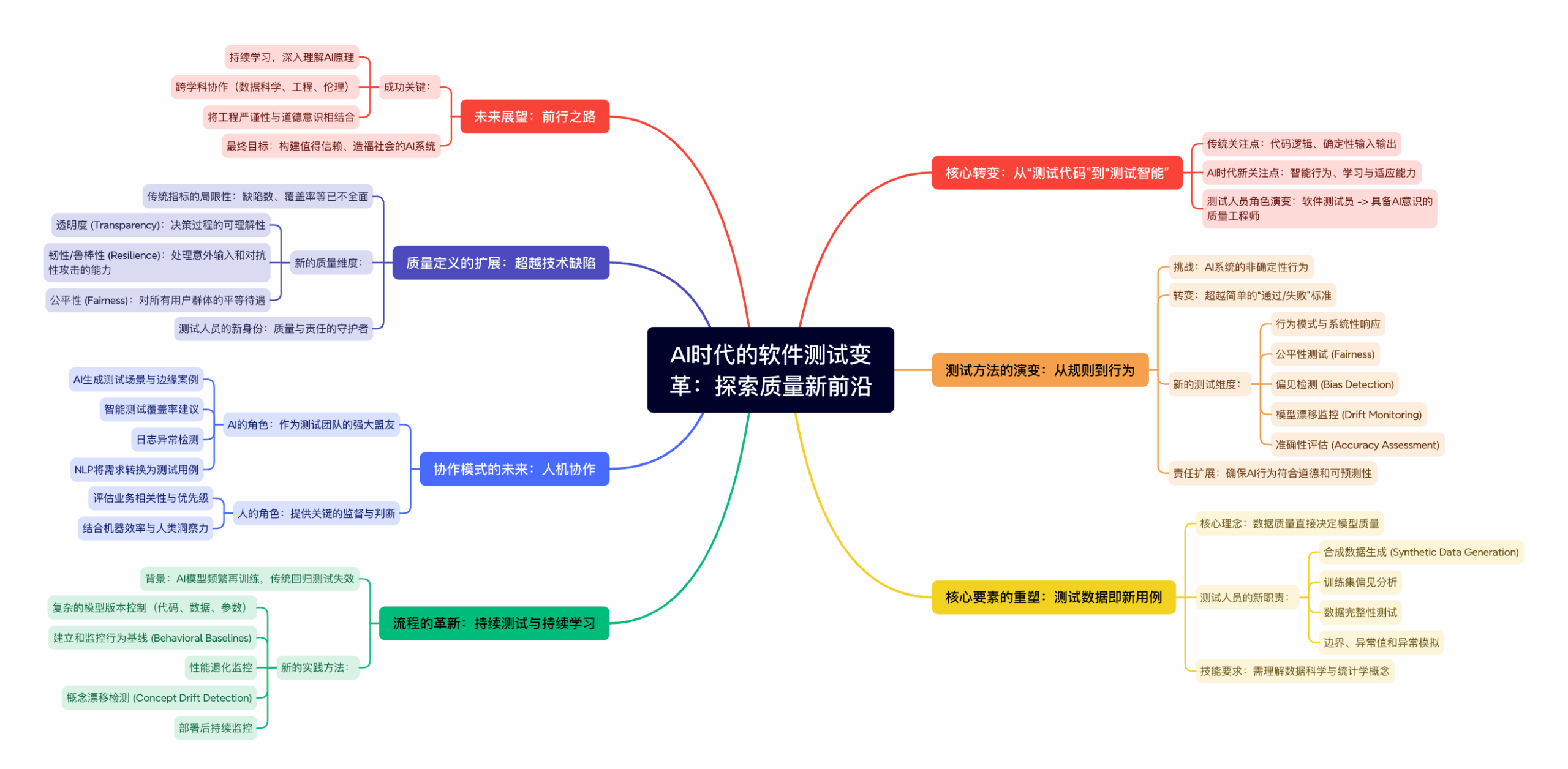

内容总结

这篇文章的核心观点是,人工智能(AI)的崛起正在从根本上改变软件测试的性质,使其从传统的“测试代码”演变为更复杂的“测试智能”。这一转变要求测试人员(现在是具备AI意识的质量工程师)掌握新技能,并采用全新的方法论和思维模式。

文章主要阐述了以下几个关键转变:

1. 从基于规则到基于行为:

传统测试依赖确定性的输入和可预测的输出。而AI系统具有非确定性,会学习和演化,因此测试必须转向关注其行为模式、公平性、偏见和模型漂移,而不仅仅是简单的“通过/失败”。

2. 数据成为核心:

在AI测试中,测试数据的质量直接决定了模型质量。测试人员的职责扩展到数据管理,包括生成合成数据、检测训练集中的偏见以及确保数据管道的完整性。测试数据本身已成为新的“测试用例”。

3. 持续测试与持续学习结合:

AI模型会频繁再训练,导致传统回归测试失效。新的流程要求引入模型版本控制、行为基线监控和概念漂移检测,并将测试延伸至部署后监控。

4. 人机协作成为新常态:

AI并非取代测试人员,而是作为强大盟友来增强他们的能力。AI可以生成复杂的测试场景、发现异常,而人类则提供业务背景、监督和最终判断。

5. 质量的定义被重塑:

软件质量不再仅限于功能正确和无缺陷。它现在包含了透明度、韧性(鲁棒性)、公平性和道德责任等更广泛的维度。测试人员的角色也演变为技术与社会责任的“守护者”。

总之,未来的软件质量保证需要测试专业人员拥抱跨学科知识,将严谨的工程实践与深刻的道德意识相结合,以构建值得信赖并造福社会的AI系统。

译文全文

随着人工智能从推荐引擎到自动化工具等领域深度融入软件系统,问题已不再是“我们如何测试代码?”,而是“我们如何测试智能?”。欢迎来到AI增强的软件测试时代,在这里,仅靠传统方法已无法胜任。到了2025年,软件测试人员正在演变为具备AI意识的质量工程师,重塑着产品可靠性的未来。

这种根本性的转变不仅代表了测试方法的演进,更是对智能世界中质量保证涵义的彻底重构。过去,我们依赖确定性的输入产生可预测的输出;而现在,我们面对的是能够学习、适应,并时常以其行为给我们带来意外的系统。这一转型要求测试专业人员不仅要理解代码逻辑,还要掌握机器学习模型、数据管道和算法决策过程中的精妙之处。

从基于规则的测试到基于行为的测试

在传统测试中,我们使用预定的测试用例和固定场景,根据已知预期来验证输出。但AI驱动的系统常常表现出非确定性行为——它们基于新数据进行学习和演化,这使得传统的黑盒测试方法已显不足。这种范式转变要求测试人员超越简单的“通过/失败”标准,转而关注行为模式和系统性响应。

现代AI测试涉及评估模式而非离散结果,这要求测试人员培养统计分析和行为建模方面的新技能。他们必须创建数据驱动的测试场景,以应对可能导致模型漂移或性能下降的边缘案例和意外输入。如今的验证范围已涵盖公平性测试,以确保AI系统不会歧视特定用户群体;偏见检测,以识别有失偏颇的决策;漂移监控,以捕捉模型偏离预期行为的情况;以及跨越不同数据段和时间周期的准确性评估。

质量保证团队现在负责确保AI在道德和可预测性方面表现良好,其职责已远远超出传统软件缺陷的范畴。这意味着需要理解算法决策的社会影响,并实施能够检测AI系统何时可能造成伤害或固化不公实践的测试框架。

测试数据即新测试用例

对于机器学习系统而言,数据质量直接决定了模型质量,这使得数据管理成为测试流程的关键组成部分。与传统软件中精心设计场景的测试用例不同,AI测试在很大程度上依赖于训练和验证数据集的质量、多样性和代表性。一个有缺陷的数据集,即使底层代码完美无瑕,也可能悄无声息地破坏AI的功能。

测试人员现在积极参与用于模型验证的合成数据生成,创建能够安全测试边缘案例而无需暴露敏感真实世界信息的人工数据集。他们在训练数据集中进行偏见检测,通过分析数据分布来识别不公平或歧视性结果的潜在来源。数据完整性测试确保输入管道在整个数据处理工作流中保持一致性和准确性,而边界测试则验证系统如何响应超出预期参数范围的输入。

异常值和异常模拟已成为测试AI鲁棒性的关键,因为这些系统在现实世界中经常遇到与训练条件显著不同的数据。测试人员现在必须理解数据科学概念、统计分布以及数据特征与模型性能之间的关系。这一扩展的角色要求他们与数据科学家和机器学习工程师协作,以确保全面覆盖与数据相关的潜在故障模式。

持续测试与持续学习的交汇

AI模型会频繁地用新数据进行再训练,从而创造出一个动态环境,使得传统的回归测试方法迅速过时。与发布版本之间功能保持稳定的传统软件不同,AI系统在每次训练周期后,即使处理相同的输入,也可能表现出不同的行为。这一现实要求我们从根本上反思如何对智能系统进行持续集成和部署。

质量保证团队必须实施复杂的模型版本控制系统,不仅跟踪代码变更,还要跟踪数据版本、模型参数和性能基线。行为基线成为检测模型更新是否引入意外系统行为变化的关键参考点。自动化测试管道现在包括性能退化监控,以确保模型的改进不会以牺牲关键用例的准确性为代价。

概念漂移检测已成为一门至关重要的测试学科,用于监控模型在现实世界中遇到的数据模式何时开始偏离其训练条件。持续测试超越了传统的CI/CD管道,扩展到包括部署后监控,即持续根据既定基准和道德准则验证AI的行为。这种持续的警惕有助于捕捉那些只有在模型于生产环境中遇到新数据模式时才会出现的问题。

测试中的人机协作

AI驱动软件的讽刺之处在于,人工智能正在同时改变我们测试的内容和测试的方式。在2025年,AI已成为测试团队的强大盟友,是增强人类能力,而非取代人类判断。现代质量保证团队利用AI生成的测试场景,这些场景能够探索比人类测试员手动创建的组合与边缘案例多得多的情况。

智能的测试覆盖率建议有助于识别测试策略中的差距,而机器学习算法则通过分析代码复杂性和历史缺陷模式来确定测试工作的优先级。应用日志中的异常检测有助于发现可能预示着新问题的异常行为,而自然语言处理技术可以将业务需求直接转换为可执行的测试用例,从而减少利益相关者期望与技术验证之间的转换鸿沟。

然而,这种协作需要人类的监督和解读。AI工具可以生成测试场景并识别潜在问题,但必须由人类测试员在业务背景下评估这些发现的相关性和优先级。机器的效率与人类的洞察力相结合,创造出了任何一方都无法独立达到的测试能力。

重新定义AI时代的质量

传统的软件指标,如缺陷数量、测试覆盖率百分比和平均故障间隔时间,已无法全面反映AI驱动系统的软件质量。如今,质量涵盖了以往在技术测试范围之外的维度,要求对系统影响和用户体验有更全面的理解。

透明度已成为一项关键的质量指标,用于衡量用户是否能理解并信任AI模型如何处理他们的数据和决策。韧性测试(或称鲁棒性测试)评估系统如何处理可能导致AI模型以不可预测方式失败的意外输入、对抗性攻击和边缘案例。公平性评估则确保AI系统能够平等对待所有用户,无论其人口统计特征或使用模式如何。

测试人员已演变为责任的守护者,而不仅仅是质量的守护者,他们扮演的角色将技术卓越与道德问责联系在一起。这一扩展的使命要求他们理解监管要求、行业标准以及AI部署的社会影响。质量保证团队现在必须在考量传统性能和可靠性指标的同时,思考算法公正、数据隐私和长期社会影响等问题。

前行之路

软件质量的未来远远超出了代码正确性的范畴,已扩展到智能系统的保障。最优秀的质量保证团队将是那些能够从根本上学习AI系统工作原理、拥抱测试机器学习模型的专用工具,并将工程的严谨性与道德意识相结合的团队。这一转型对测试专业人员而言既是挑战也是机遇,他们可以借此扩大自身影响力,为构建能够造福社会、值得信赖的AI系统做出贡献。

要在这个新格局中取得成功,需要持续学习、跨学科协作,并致力于实现兼顾技术卓越与社会责任的质量承诺。